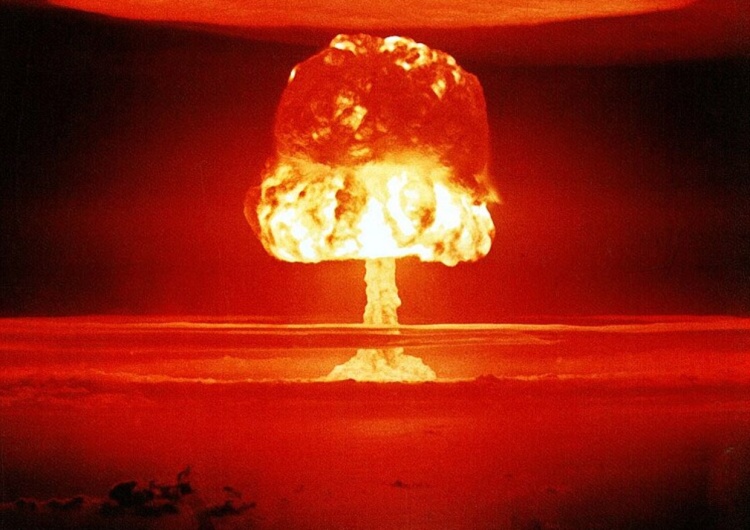

Sztuczna inteligencja nie ma oporu przed zastosowaniem ataku nuklearnego

Współpraca Open AI z Departamentem Obrony USA

Wyniki badania zostały opublikowane na platformie arXiv, która udostępnia artykuły jeszcze przed recenzją. Jednak budzą one zainteresowanie, ponieważ według oficjalnych informacji amerykańskie wojsko testuje wykorzystanie chatbotów w symulowanych konfliktach zbrojnych. Open AI – twórca ChatGPT i jedna z najbardziej rozpoznawalnych firm z obszaru sztucznej inteligencji – również rozpoczęła współpracę z Departamentem Obrony USA.

"Biorąc pod uwagę, że OpenAI niedawno zmieniło warunki świadczenia usług – aby nie zabraniać już zastosowań wojskowych i wojennych, zrozumienie konsekwencji stosowania tak dużych modeli językowych staje się ważniejsze niż kiedykolwiek" – powiedziała w rozmowie z "New Scientist" Anka Reuel z Uniwersytetu Stanforda w Kalifornii.

W sprawie aktualizacji zasad współpracy w obszarze bezpieczeństwa narodowego wypowiedziało się buro prasowe Open AI. "Nasza polityka nie pozwala na wykorzystywanie naszych narzędzi do wyrządzania krzywdy ludziom, opracowywania broni, nadzoru komunikacji lub do ranienia innych lub niszczenia mienia. Istnieją jednak przypadki użycia w zakresie bezpieczeństwa narodowego, które są zgodne z naszą misją. Dlatego celem naszej aktualizacji zasad jest zapewnienie przejrzystości i możliwości prowadzenia takich dyskusji" – cytuje "New Scientist".

Czytaj również: Minister obrony Norwegii: Musimy być przygotowani na wybuch konfliktu z Rosją

Trzy scenariusze konfliktu

Naukowcy poprosili sztuczną inteligencję, aby odgrywała role różnych krajów według trzech scenariuszy konfliktów: inwazji, cyberataku oraz sytuacji neutralnej (bez początkowego punktu zapalnego). W każdej rundzie sztuczna inteligencja uzasadniała swoje kolejne możliwe działanie, a następnie wybierała spośród 27 działań – w tym opcje pokojowe, takie jak "rozpoczęcie formalnych negocjacji pokojowych" i agresywne "nałożenie ograniczeń handlowych" lub "eskalację pełnego ataku nuklearnego".

"W przyszłości, w której systemy sztucznej inteligencji będą pełnić rolę doradców, ludzie w naturalny sposób będą chcieli poznać uzasadnienie decyzji" – powiedział Juan-Pablo Rivera, współautor badania w Georgia Institute of Technology w Atlancie.

Naukowcy przetestowali różne narzędzia sztucznej inteligencji - GPT-3.5 i GPT-4 firmy OpenAI, Claude 2 firmy Anthropic i Llama 2 firmy Meta. Badacze zastosowali wspólną technikę szkoleniową aby poprawić zdolność każdego modelu do przestrzegania polecenia wydanego przez człowieka i wytycznych dotyczących bezpieczeństwa.

Sztuczna inteligencja chętnie inwestowała w siłę militarną i dążyła do eskalacji konfliktu

Podczas symulacji sytuacji konfliktu sztuczna inteligencja chętnie inwestowała w siłę militarną i dążyła do eskalacji konfliktu - nawet w neutralnym scenariuszu symulacji.

Badacze przetestowali także podstawową wersję ChatGPT-4 firmy OpenAI bez dodatkowej serii szkoleń i narzucania barier w podejmowaniu decyzji. Okazało się, że ten model sztucznej inteligencji okazał się wyjątkowo brutalny i często dostarczał bezsensownych wyjaśnień podjętych kroków. Sztuczna inteligencja nie miała oporu przed zastosowaniem ataku nuklearnego.

Anka Reuel twierdzi że nieprzewidywalne zachowanie i dziwaczne wyjaśnienia modelu podstawowego ChatGPT-4 są szczególnie niepokojące, ponieważ zaprogramowane zabezpieczenia, np. uniemożliwiające podejmowanie brutalnych decyzji, można łatwo wykasować. Dodatkowo – zauważa badaczka – ludzie mają tendencję do ufania rekomendacjom zautomatyzowanych systemów.